PCA

# Tag:

- Source/KU_ML

PCA (Principal component analysis)

- Variance가 크다는 것은, 데이터의 변동성을 많이 설명하고 있는 축이라는 것을 의미한다.

- 차원 축소: 정보의 손실을 최소화 하면서, 차원을 줄여 **차원의 저주(curse of dimensionality)**를 피할 수 있다.

Linear Transformation for new random vector(new principal axis)

이에 따라 생기는 Variance와 Covariance의 연산 성질을 알 필요가 있다.

Projection of random vector on

Let

- Mean: ,

- Variance:

Linear Transform of random vector on

Let : 새로운 축으로 변형하는 것이라 볼 수 있다.

- Mean:

- Covariance:

PCA

라고 가정하자. 이 때, 의 크기가 1이라는 constraints가 걸려 있으므로 최적화 조건은

의 과정이라 할 수 있며, 이에 따라 Lagrange Multiplier에 따라 convex optimzation을 진행하면

- :

이는 곧, : Eigen decomposition의 문제로 변형되며, 는 eigenvector, 는 eigenvalue이자 새로운 축의 Variance가 된다.

위의 식에 를 곱하면, 와 같이 변형되는데, 이므로, 이는 곧 새로운 축 의 분산이 임을 의미한다.

즉, 를 Eigen decomposition하여 나타낸 것을

로 나타낼 수 있고, Variance가 큰, 즉 Eigenvalue가 큰 순서대로의 Eigenvector들을 Principal Axis로 한다.

: 이므로, 곧 이는 새로운 Domain에서 바라보는 Covariance Matrix임을 의미한다. 이 때, Eigenvalue Matrix는 Diagonal 행렬이므로 이는 다른 축과의 Correlation이 없음을 의미한다.

(는 symmetric and semi-positive-definite하므로, )

Eigenvalue와 Eigenvector의 Linear Independent

만일 Eigenvalue의 중복이 일어나더라도, 그 EigenValue의 Nul Space에서 서로 Linear indendent한 Eigenvector를 찾을 수 있다.

For second principal component

결국 이는, 와 orthogonal한 새로운 두번째 principal axis 를 찾는다하여 optimization 문제를 풀어도, Eigenvector가 임을 보여준다.

- :

위에 식에 를 곱해 식을 전개하면, 결국에는 라는, Eigen decomposition의 식이 나오게 된다.

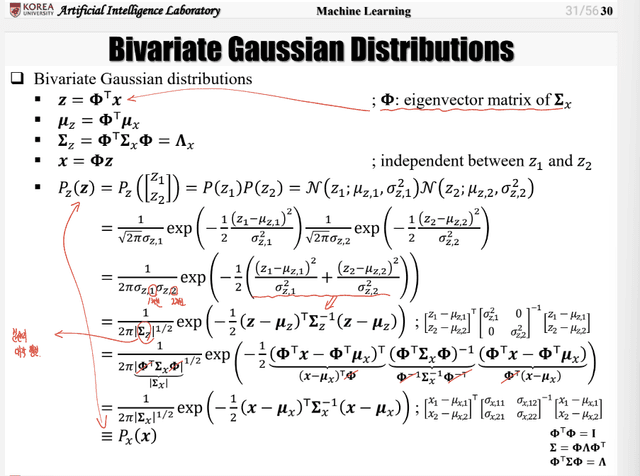

For [[../../../../Mathematics/Probability/Distribution/Multivariate Distribution/MVN]]

즉, 라는 것이다.

- 수정수정